hadoop家族操作大数据还是很给力的。今天就测试了一把,还行。

1,准备测试数据

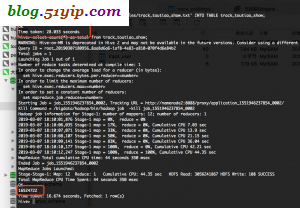

# du -ah 2.9G ./track_toutiao_show.txt

2,导入

导入1600多万条,28秒多,还是挺给力的。

hive> select aid,cid from track_toutiao_show limit 20; OK 1624232561947693 1624233095655437 1624232561947693 1624233095655437 1624232561947693 1624233095655437 1624232561947693 1624233095655437 1624232561947693 1624233095529528 1624232561947693 1624233095655437 1624232561947693 1624233095655485 1624232561947693 1624233095655437 1624232561947693 1624233095655485 1624232561947693 1624233095529528 1624232561947693 1624233095655437 1624232561947693 1624233095655437 1624232561947693 1624233095529528 1624232561947693 1624233095655437 1624232561947693 1624233095529528 1624232561947693 1624233095655437 1624232561947693 1624233095655437 1624232561947693 1624233095655437 1624232561947693 1624233095655453 1624232561947693 1624233095655485 Time taken: 0.139 seconds, Fetched: 20 row(s)

转载请注明

作者:海底苍鹰

地址:http://blog.51yip.com/hadoop/2081.html